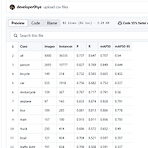

COCO Pretrained YOLOv8 클래스별 AP

COCO Pretrained YOLOv8 클래스별 AP

https://github.com/developer0hye/coco-pretrained-yolov8-ap-per-class GitHub - developer0hye/coco-pretrained-yolov8-ap-per-class: The Average Precision per class for the YOLOv8 model pre-trained onThe Average Precision per class for the YOLOv8 model pre-trained on the COCO dataset - developer0hye/coco-pretrained-yolov8-ap-per-classgithub.com mAP만 보기엔 정보가 너무 함축돼있어서 다른 클래스에 대한 여러 메트릭 값을 csv파일로 저장하여..

아아... Docker Container에서 nvidia-smi 를 입력하니 Failed to initialize NVML 라는 에러 메시지가 뜨면서 GPU 인식이 안된다. 도커를 재설치했다. 안된다. 최신 GPU Driver를 설치했다. 안된다. Nvidia 도커를 재설치했다. 안된다 https://kimfra.com/55817c380fa949fbbfe16626a49c007b [CUDA]Failed to initialize NVML: Unknown Error 오류쿠버네티스 파드에서 GPU 를 사용할 때 발생하는 오류 해결 방법을 알아보았다.kimfra.comprivileged 를 True로 줬다. 되긴됐다. 근데 컨테이너 상에서 내가 Docker compose파일에 지정한 GPU 말고 다른 GPU들도..

Sapiens: Foundation for Human Vision Models 리뷰

Sapiens: Foundation for Human Vision Models 리뷰

Sapiens 프로젝트 페이지 Sapiens | MetaFoundation models for human vision tasksabout.meta.com Sapiens 깃허브 Repo GitHub - facebookresearch/sapiens: High-resolution models for human tasks.High-resolution models for human tasks. Contribute to facebookresearch/sapiens development by creating an account on GitHub.github.com Sapiens Arxiv Sapiens: Foundation for Human Vision ModelsWe present Sapiens, a family ..

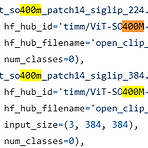

Getting ViT in Shape:Scaling Laws for Compute-Optimal Model Design

Getting ViT in Shape:Scaling Laws for Compute-Optimal Model Design

심심하면 timm 프로젝트에 어떤 모델들 추가되는지 확인하는데 며칠전에 보다가 vit_so400m~ 이런 모델이 있는 걸 알게됐다. https://github.com/huggingface/pytorch-image-models/blob/main/timm/models/vision_transformer.py pytorch-image-models/timm/models/vision_transformer.py at main · huggingface/pytorch-image-modelsThe largest collection of PyTorch image encoders / backbones. Including train, eval, inference, export scripts, and pretrained weig..

여러 폴더 밑에 Stand라는 폴더가 있었고 나는 이걸 하나의 폴더로 옮기고 싶었다. mv ./*/Stand ./Total/ 그러니까 mv: cannot move ~ Directory not empty 이런 에러가 뜨더라 챗지피티한테 물었다. find ./*/Stand -type f -exec mv {} ./Total/Stand/ \; *주의: ./Total/Stand 라는폴더가 이미 존재해야함 음... 역시 챗지피티야

unzip *.zip 했을때 filename not matched 라는 caution 이 떠서 Claude 한테 물어보니, 아래 같이 하라고 Claude가 알려줬다. 나는 for zip in *.zip; do unzip "$zip"; done 로 해결했다. The issue you're encountering is due to how the shell is interpreting the wildcard (*) in your unzip command. Let me explain what's happening:When you use unzip *.zip, the shell expands this wildcard before passing it to the unzip command.In this case,..

- Total

- Today

- Yesterday

- Lowest Common Ancestor

- cosine

- 순열

- 백준

- 백준 1766

- 조합

- 파이참

- C++ Deploy

- 백트래킹

- LCA

- MOT

- FairMOT

- 인공지능을 위한 선형대수

- 가장 긴 증가하는 부분 수열

- 백준 11053

- ㅂ

- 단축키

- 위상 정렬 알고리즘

- 자료구조

- 문제집

- PyCharm

- 이분탐색

- 백준 11437

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |