티스토리 뷰

Getting ViT in Shape:Scaling Laws for Compute-Optimal Model Design

developer0hye 2024. 8. 25. 10:10심심하면 timm 프로젝트에 어떤 모델들 추가되는지 확인하는데 며칠전에 보다가 vit_so400m~ 이런 모델이 있는 걸 알게됐다.

https://github.com/huggingface/pytorch-image-models/blob/main/timm/models/vision_transformer.py

pytorch-image-models/timm/models/vision_transformer.py at main · huggingface/pytorch-image-models

The largest collection of PyTorch image encoders / backbones. Including train, eval, inference, export scripts, and pretrained weights -- ResNet, ResNeXT, EfficientNet, NFNet, Vision Transformer (V...

github.com

찾아보니 Getting ViT in Shape: Scaling Laws for Compute-Optimal Model Design 이 논문에서 나온거더라

구글 딥마인드에서 연구됐다.

제목이 재밌다.

제목에서 알 수 있듯이 ViT Scaling 을 잘해보자! 가 메인 주제인 거 같다.

내가 관심있는 부분은 그냥 이걸 가져다 써보는 거라 논문은 대충 읽고 Claude한테 요약해달라고 하고 쓱 읽어보기만 했다.

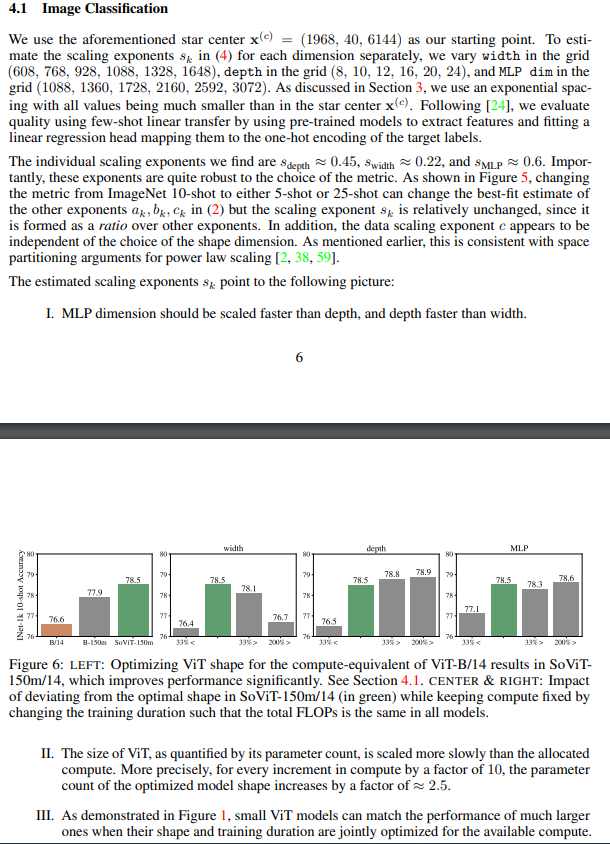

Image Classification Task로 보자면 Scaling 시 1. MLP dimension, 2. Depth, 3. Width 순으로 Weight을 주는 게 좋다고 한다.

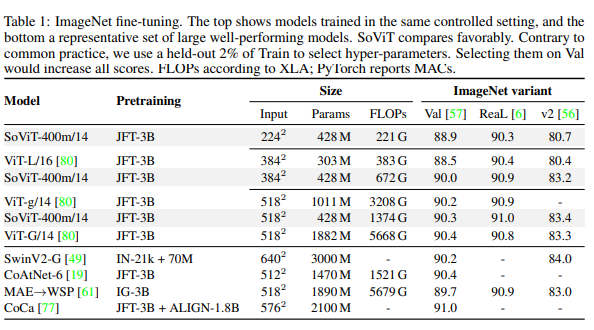

그래서 잘 찾은 Scaling 방법으로 400M 사이즈 모델(=SoViT-400m/14, timm에서는 vit_so400m~) 을 만든 다음 기존에 사이즈 비슷한 ViT-L(303M)과 사이즈가 훨씬 큰 ViT-G(1882M)과 비교해보니까 좋은 성능을 보였다고한다.

다양한 Image Classification Dataset에서 좋은 성능을 보이고 있다. 근데 Birds 데이터셋에서는 L보다 성능이 훨씬 낮다.

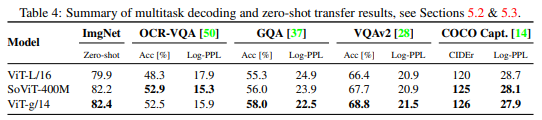

다른 Task에서도 400M모델의 성능을 기존 ViT-L과 ViT-g(ViT-G랑 다름! 사이즈는 1011M) 랑 비교해봤다고 한다,.

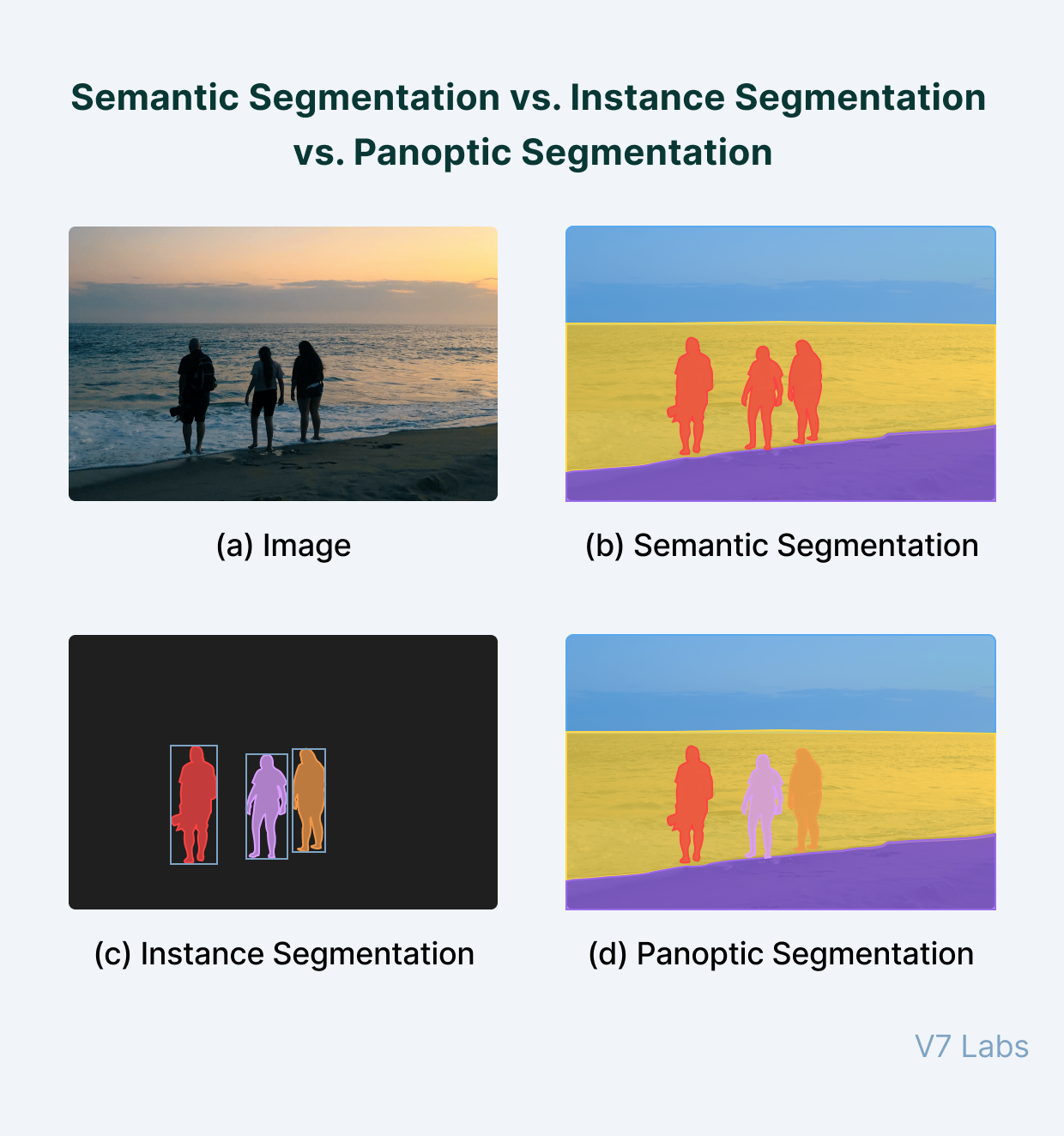

Image Classification Task를 중점적으로 찾아진 Scaling 법칙을 따랐다보니 Panoptic Segmentation Task에서는 -L보다는 좋지만 -g 보다는 성능이 크게 낮다.

또 다른 Task들에 대해서도 실험해봤다고 한다.

ViT-g(1011M) 랑 엇 비슷한 수준을 보였다고한다.

'Deep Learning' 카테고리의 다른 글

| COCO Pretrained YOLOv8 클래스별 AP (0) | 2024.09.13 |

|---|---|

| Sapiens: Foundation for Human Vision Models 리뷰 (0) | 2024.08.26 |

| 그냥 요즘 느끼는 점에 대한 글 (0) | 2024.08.04 |

| 20240728 shift-invariant cnn 관련 흥미로워 보이는 논문 3개 기록, 근데 나이퀴스트 이론을 곁들인 (0) | 2024.07.28 |

| 즉흥적으로 기록해놓는 Video Classification 관련 참고 자료 (0) | 2024.07.13 |

- Total

- Today

- Yesterday

- LCA

- 단축키

- 자료구조

- C++ Deploy

- 파이참

- 백준 11053

- PyCharm

- ㅂ

- 백준 11437

- 백준 1766

- 순열

- cosine

- 문제집

- 인공지능을 위한 선형대수

- 조합

- MOT

- 가장 긴 증가하는 부분 수열

- 위상 정렬 알고리즘

- 이분탐색

- FairMOT

- 백트래킹

- 백준

- Lowest Common Ancestor

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |