티스토리 뷰

20240728 shift-invariant cnn 관련 흥미로워 보이는 논문 3개 기록, 근데 나이퀴스트 이론을 곁들인

developer0hye 2024. 7. 28. 00:44Making Convolutional Networks Shift-Invariant Again

https://richzhang.github.io/antialiased-cnns/

Making Convolutional Networks Shift-Invariant Again.

R. Zhang. In ICML 2019.

richzhang.github.io

Video에 대해 detection 모델 추론시켜보면 프레임 단위로 큰 차이가 없는 거 같은데 객체가 살짝 이동했다고해서, 혹은 코덱에 의해 발생하는 약간의 열화에도 결과값에 대한 변화가 굉장히 큰 경우를 자주 보곤했다. 뭐 이론적으로 배울때는 CNN이 Pooling에서 어쩌구 저쩌구..., Strided Convolution에서 어쩌구 저쩌구... 하면서 이동에 Robust하다고 말은 하는데 실제로 Real world 데이터를 처리해보면 항상 그렇지는 않은 거 같다. 그래서, 이 논문 저 논문 찾아보다가 흥미로워 보이는 논문을 발견해서 기록해둠. Pooling 될때, Strided Conv 거칠때 적절한 시점에 anti-aliasing을 해주면 모델이 더 shift에 robust해지지 않을까 라는 게 아이디어로 받아들여진다. 컴퓨터 비전, 신호처리 배웠으면 사실 머리 속으로 생각은 해봤을법한 내용 같은데 역시나 누가 예~전에 이미 해봤었다. 역시 기초가 탄탄해야지 이런 방법을 떠올리겠구나 싶다.

Detection 모델에 downsampling 되는 레이어에 이 기법 한 번 적용해보고 싶어졌다. 해봐야겠다!

관련된 다른 연구도 한 개 더 첨부함

Impact of Aliasing on Generalization in Deep Convolutional Networks

claude 한테 요약해보라고 했는데 잘하는 거 같다. 애용해야지

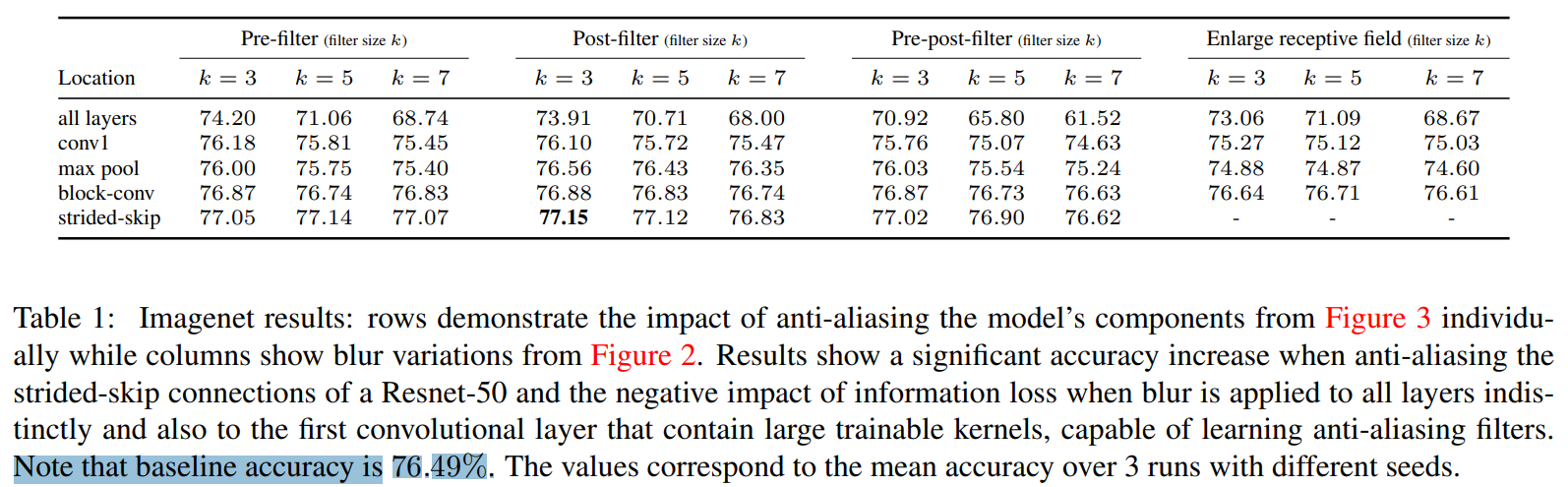

결론은 stride 2 이상인 conv 레이어 쪽에서 low-pass 필터를 적용시켜주면 좋다는 게 결론이다. 무지성으로 모든 레이어(all layers)에 넣으면 성능이 저하된다. (Baseline 76.49 vs all layers) 커널 사이즈도 3x3 정도면 충분하다.

alaising 이 발생할 수 있는 layer 부근에 적용해보면 될 거 같다.

트랜스포머도 관련 연구가 있다.

https://proceedings.neurips.cc/paper/2021/file/2b3bf3eee2475e03885a110e9acaab61-Paper.pdf

앨리어싱 보니까 대학교때 신호 처리 과목에서 나이퀴스트 이론 배운 거 생각난다.

'Deep Learning' 카테고리의 다른 글

| Getting ViT in Shape:Scaling Laws for Compute-Optimal Model Design (0) | 2024.08.25 |

|---|---|

| 그냥 요즘 느끼는 점에 대한 글 (0) | 2024.08.04 |

| 즉흥적으로 기록해놓는 Video Classification 관련 참고 자료 (0) | 2024.07.13 |

| 20240711 논문을 읽어봐야 할 거 같은 Object Detection 방법이 나온 거 같다! LW-DETR: A Transformer Replacement to YOLO for Real-Time Detection (0) | 2024.07.11 |

| Depth Anything v2 엄청나보이는 Monocular Depth Estimation 모델 (0) | 2024.06.19 |

- Total

- Today

- Yesterday

- 위상 정렬 알고리즘

- 자료구조

- 이분탐색

- 백준 1766

- 문제집

- 백준

- LCA

- 순열

- MOT

- 백트래킹

- 백준 11053

- 단축키

- 백준 11437

- 가장 긴 증가하는 부분 수열

- PyCharm

- ㅂ

- 파이참

- FairMOT

- cosine

- 인공지능을 위한 선형대수

- C++ Deploy

- 조합

- Lowest Common Ancestor

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |