티스토리 뷰

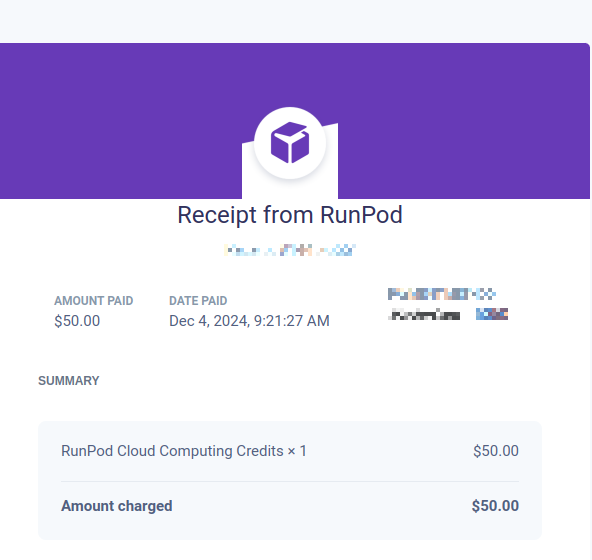

또 50달러를 추가 결제했다... 지금까지 총 150달러를 태웠다. 슬슬 부담된다.

네트워크 스토리지 200기가바이트에 4090 1대로 주로 학습중이다... 참고로 학습중인 모델은 Qwen2vl7b다. 입력 이미지 사이즈에 대한 튜닝을 통해 메모리를 조금이라도 줄여줬더니만 배치 사이즈1로 간신히 돌아간다. 지금 학습 이미지가 300장 이정도 밖에 안되는데 꽤나 미친 성능을 보여준다. 한 1만장, 5만장, 10만장 정도 되면 어느정도로 성능이 나올지 너무 궁금하다. 아직까지는 간혹다가 LLM특유의 할루시네이션 마냥 이상한 값을 반환한다거나 특정 값을 계속해서 반환하는 문제가 있다. 나는 OCR Task를 수행하도록 파인튜닝 시켜보고 있는데 예를 들면 아래 처럼 값이 나올때가 있다.

파인튜닝을 시키는 족족 크게 완화가 돼서 좀 안심인 부분이긴한데 아쉽긴하다.

뭔가 Qwen2.5VL 이라거나 Qwen3VL 이런 거 나올때쯤이면 정말 VLM이 독립적인 태스크에 특화되어 디자인된 모델보다 동일 태스크에서 비슷한 성능을 보일지도 모른다는 생각이 든다.

'Deep Learning' 카테고리의 다른 글

| FROM CLIP TO DINO: VISUAL ENCODERS SHOUT IN MULTI-MODAL LARGE LANGUAGE MODELS, CLIP과 DINOv2 모델을 잘 Ensemble해보자 (0) | 2024.12.09 |

|---|---|

| Qwen2vl 7b 파인튜닝 최적의 하이퍼 파라미터를 찾아서... (2) | 2024.12.05 |

| Qwenvl2 7b 파인튜닝 실마리를 찾다!!! (3) | 2024.12.02 |

| unsloth/LaTeX_OCR 로 5 에폭 파인튜닝 시킨 Qwen2VL7b 또한 아쉬울 따름 (0) | 2024.12.01 |

| unsloth/LaTeX_OCR 로 1 에폭 파인튜닝 시킨 Qwen2VL7b 는 아쉬울 따름 (0) | 2024.11.30 |

댓글

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

링크

TAG

- LCA

- 백준 1766

- 파이참

- ㅂ

- 가장 긴 증가하는 부분 수열

- 순열

- PyCharm

- 문제집

- Lowest Common Ancestor

- 위상 정렬 알고리즘

- 단축키

- 백트래킹

- 백준

- 백준 11053

- MOT

- 조합

- 인공지능을 위한 선형대수

- 이분탐색

- cosine

- 백준 11437

- C++ Deploy

- FairMOT

- 자료구조

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

글 보관함