티스토리 뷰

Deep Learning

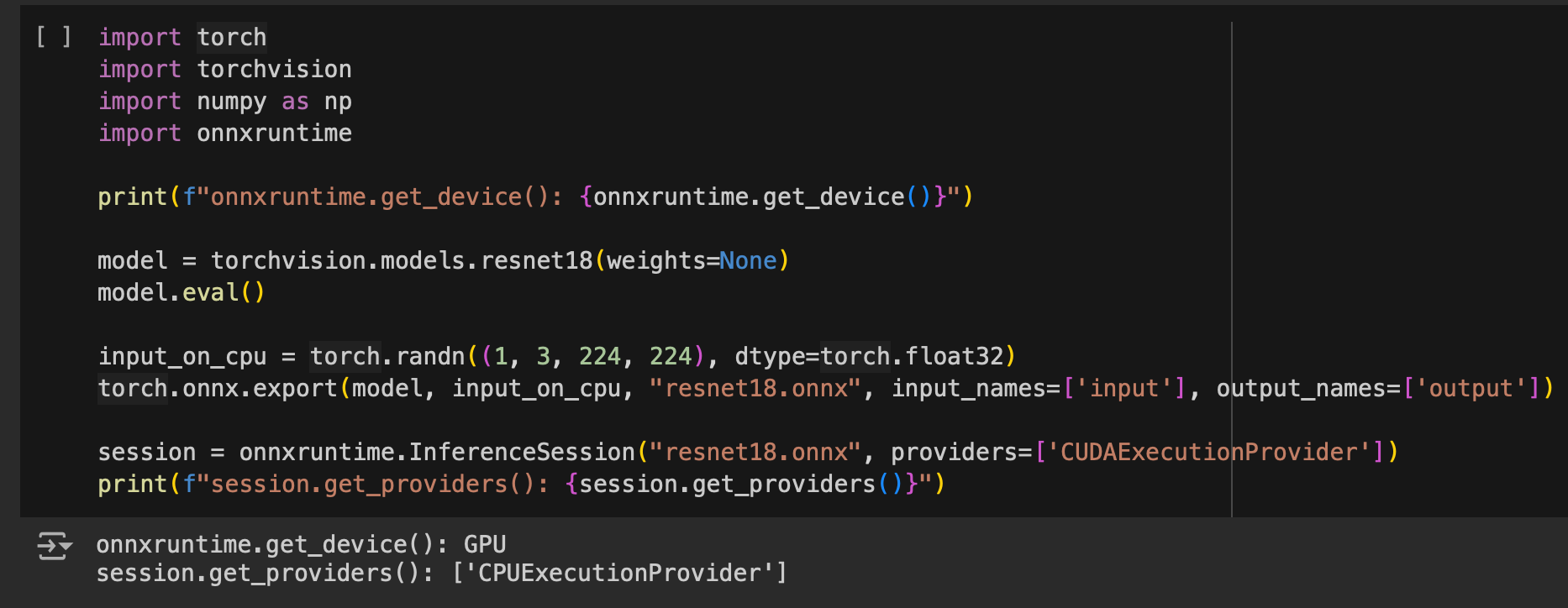

20240519 Colab 에서는 onnxruntime cuda provider 가 동작하지 않는 거 같다.

developer0hye 2024. 5. 19. 20:46import torch

import torchvision

import numpy as np

import onnxruntime

print(f"onnxruntime.get_device(): {onnxruntime.get_device()}")

model = torchvision.models.resnet18(weights=None)

model.eval()

input_on_cpu = torch.randn((1, 3, 224, 224), dtype=torch.float32)

torch.onnx.export(model, input_on_cpu, "resnet18.onnx", input_names=['input'], output_names=['output'])

session = onnxruntime.InferenceSession("resnet18.onnx", providers=['CUDAExecutionProvider'])

print(f"session.get_providers(): {session.get_providers()}")

위 코드를 Colab에서 실행시켜봤다.

GPU로 추론되려면 session.get_providers()를 호출했을때 CUDAExe... 가 나와야하는데 CPUExe... 만 나오고 안나온다.

'Deep Learning' 카테고리의 다른 글

| LLM Zero shot Chain of Thought (0) | 2024.06.12 |

|---|---|

| LLM Chain of Thought (0) | 2024.06.09 |

| RT DETR의 Uncertainty-minimal Query Selection 은 무엇일까 (0) | 2024.04.21 |

| RT DETR의 Encoder 는 무엇일까 (4) | 2024.04.21 |

| RT DETR의 백본은 무엇일까 (0) | 2024.04.16 |

댓글

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

링크

TAG

- 가장 긴 증가하는 부분 수열

- 백준

- 단축키

- FairMOT

- 이분탐색

- 순열

- 백트래킹

- LCA

- PyCharm

- 백준 1766

- 문제집

- ㅂ

- 백준 11053

- 파이참

- 자료구조

- cosine

- 위상 정렬 알고리즘

- MOT

- 백준 11437

- Lowest Common Ancestor

- 조합

- 인공지능을 위한 선형대수

- C++ Deploy

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

글 보관함