티스토리 뷰

https://ai.meta.com/blog/v-jepa-yann-lecun-ai-model-video-joint-embedding-predictive-architecture/

V-JEPA: The next step toward advanced machine intelligence

Previous work had to do full fine-tuning, which means that after pre-training your model, when you want the model to get really good at fine-grained action recognition while you’re adapting your model to take on that task, you have to update the paramete

ai.meta.com

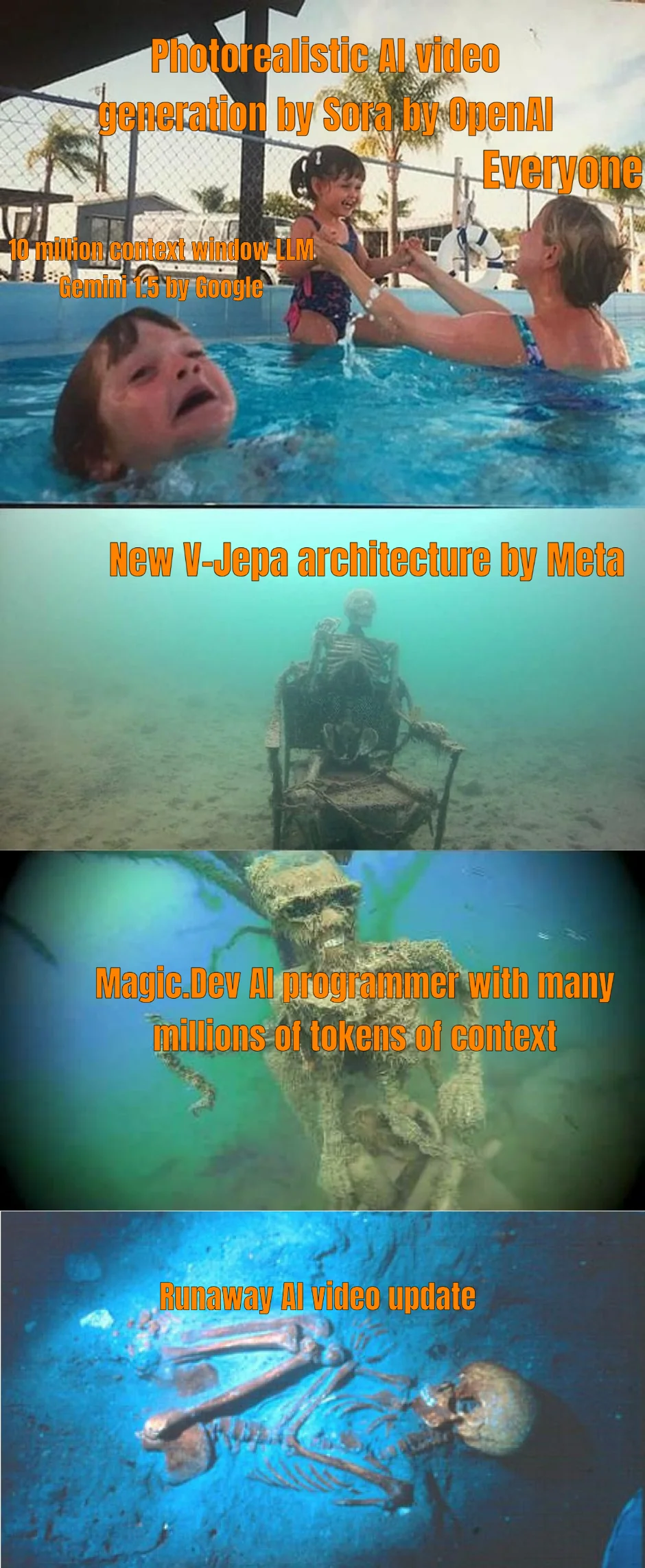

SORA에 의해 좀 묻힌 거 같은 META에서 새로 제안한 Video 기반 unsupervised learning 방법입니다. Masked Video를 모델에 입력했을때 출력되는 Feature 와 EMA로 업데이트 되는 모델에 원본 Video를 입력했을때 출력되는 Feature와의 차이를 줄이는 학습 방법을 제안했습니다.

Video 관련 태스크에서는 기존의 unsupervised 혹은 self-supervised learning 방법들 보다 뛰어난 성능을 보여주고 있습니다. 아직은 Image 관련 태스크에서는 Image만을 고려하여 설계된 방법들 보다는 성능이 크게 떨어지는 모습을 보이고는 있으나, 몇개월 정도 기다려보면 이제 Video에서도, Image에서도 모두 뛰어난 성능을 보이는 논문이 공개되지 않을까 기대됩니다. 혹시 DINOv3 ...?!

'Deep Learning' 카테고리의 다른 글

| ConvNet vs ViT 비교 논문 (0) | 2024.02.29 |

|---|---|

| 20240222 YOLOv9 가 공개되다. (0) | 2024.02.22 |

| Google Magika 파일 종류 인식을 AI로 (0) | 2024.02.18 |

| COCO pre-trained YOLOv5, YOLOv8의 입력 이미지 사이즈와 COCO 데이터셋의 이미지 해상도 (0) | 2024.02.12 |

| PCIe 5.0 지원 메인보드가 나왔구나 (1) | 2024.02.11 |

- Total

- Today

- Yesterday

- 단축키

- 가장 긴 증가하는 부분 수열

- LCA

- 이분탐색

- 백준

- 자료구조

- 백준 11053

- ㅂ

- cosine

- C++ Deploy

- MOT

- PyCharm

- 인공지능을 위한 선형대수

- 순열

- 위상 정렬 알고리즘

- 문제집

- 조합

- 백트래킹

- Lowest Common Ancestor

- 백준 11437

- FairMOT

- 백준 1766

- 파이참

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |