티스토리 뷰

Deep Learning

[Deep Learning] COCO pre-trained YOLOv8 모델의 최적의 confidence threshold 탐색

developer0hye 2023. 4. 29. 16:25실험에 사용된 프로젝트 commit id: 243fc4b1fe214ff6c27759dad51c37809db8f7f8

https://github.com/ultralytics/ultralytics

GitHub - ultralytics/ultralytics: NEW - YOLOv8 🚀 in PyTorch > ONNX > CoreML > TFLite

NEW - YOLOv8 🚀 in PyTorch > ONNX > CoreML > TFLite - GitHub - ultralytics/ultralytics: NEW - YOLOv8 🚀 in PyTorch > ONNX > CoreML > TFLite

github.com

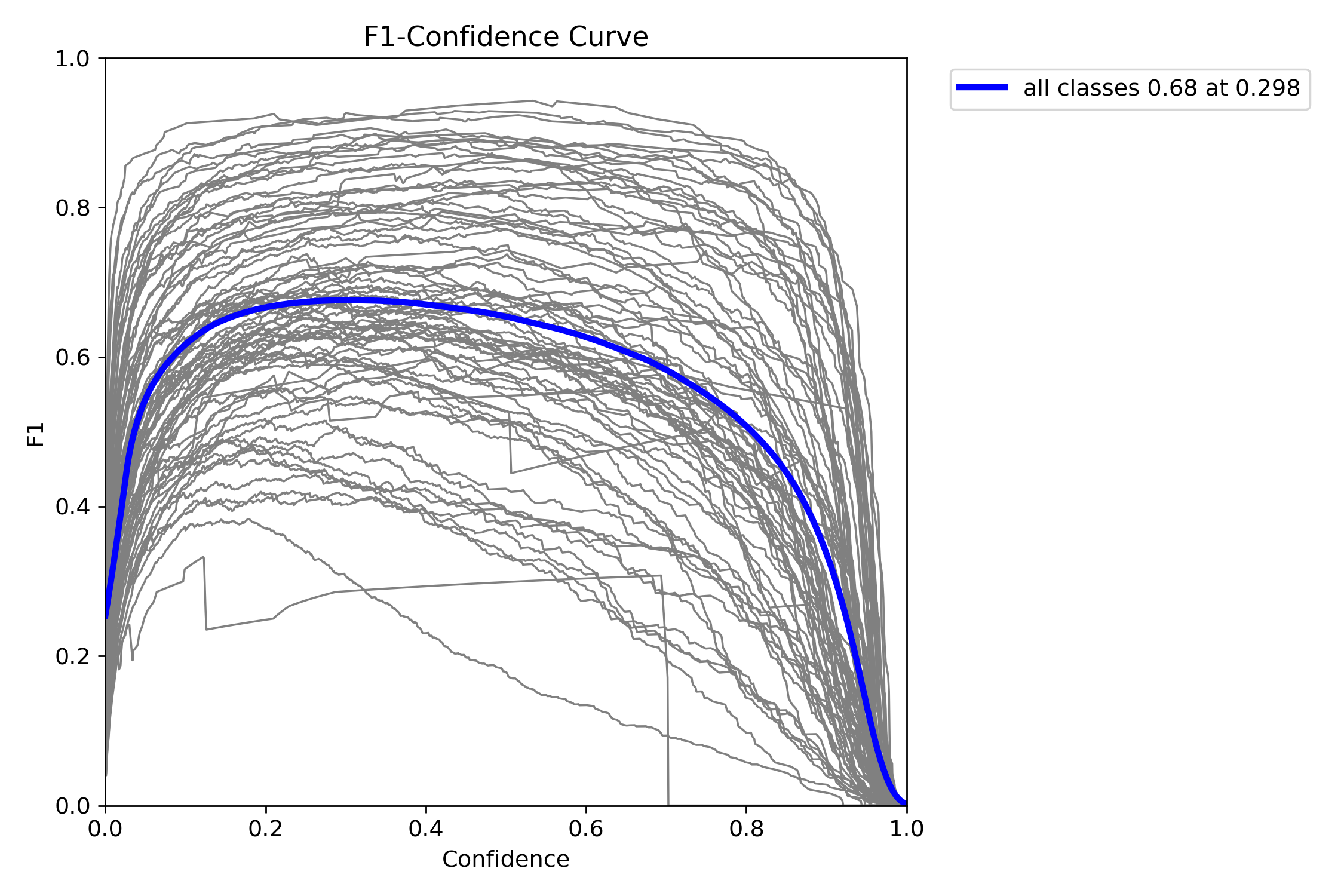

COCO dataset에 대해 validation 을 진행하여 f1 score가 best score를 갖을때의 confidence threshold 가 최적의 confidence threshold라고 정의 후 해당 값을 측정해보았다.

실행한 명령어는 아래와 같다.

yolo val task=detect model=yolov8n.pt data=coco.yaml

yolo val task=detect model=yolov8s.pt data=coco.yaml

yolo val task=detect model=yolov8m.pt data=coco.yaml

yolo val task=detect model=yolov8l.pt data=coco.yaml

yolo val task=detect model=yolov8x.pt data=coco.yaml| Model | confidence threshold | f1-score |

| YOLOv8n | 0.241 | 0.53 |

| YOLOv8s | 0.285 | 0.61 |

| YOLOv8m | 0.327 | 0.65 |

| YOLOv8l | 0.298 | 0.68 |

| YOLOv8x | 0.300 | 0.68 |

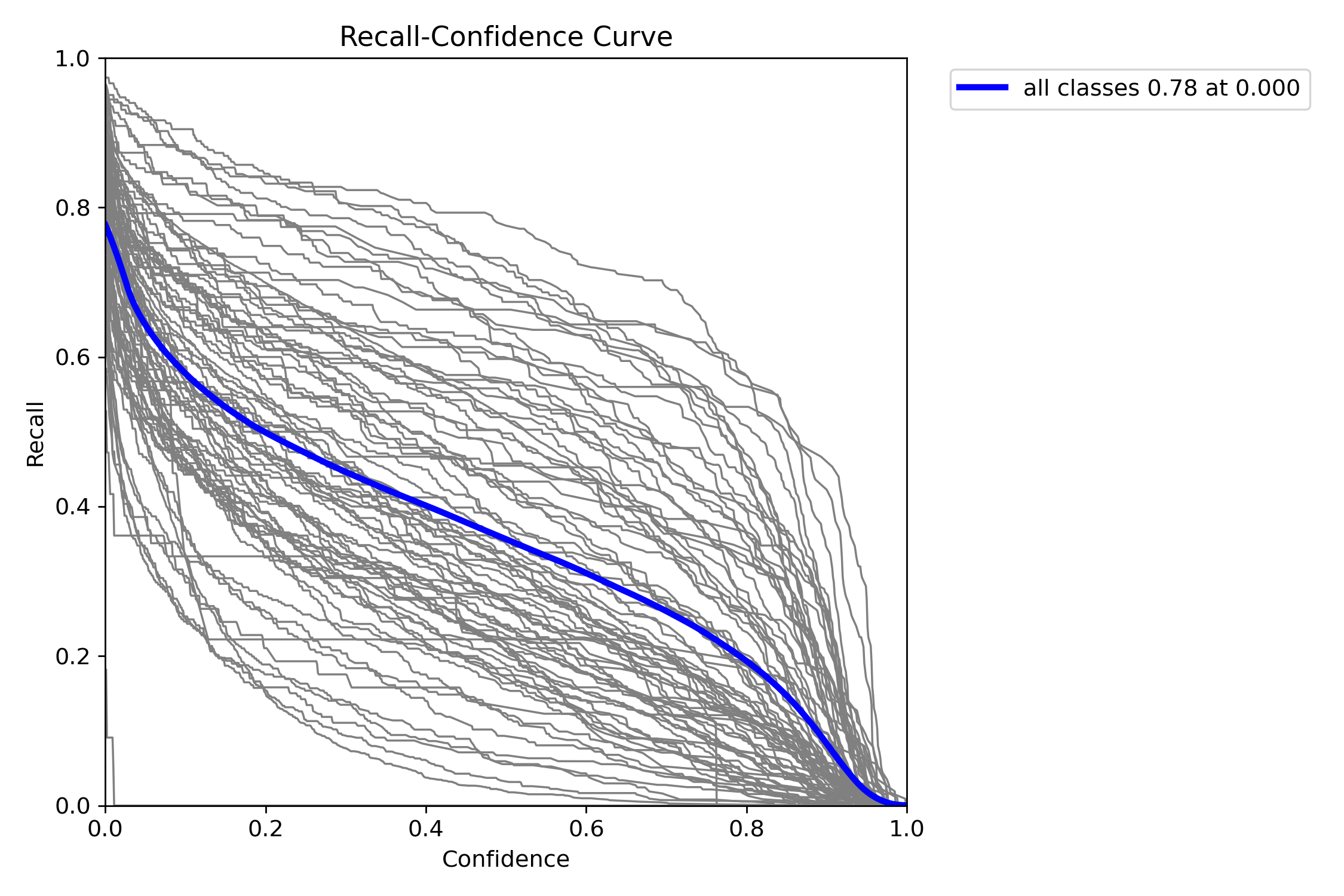

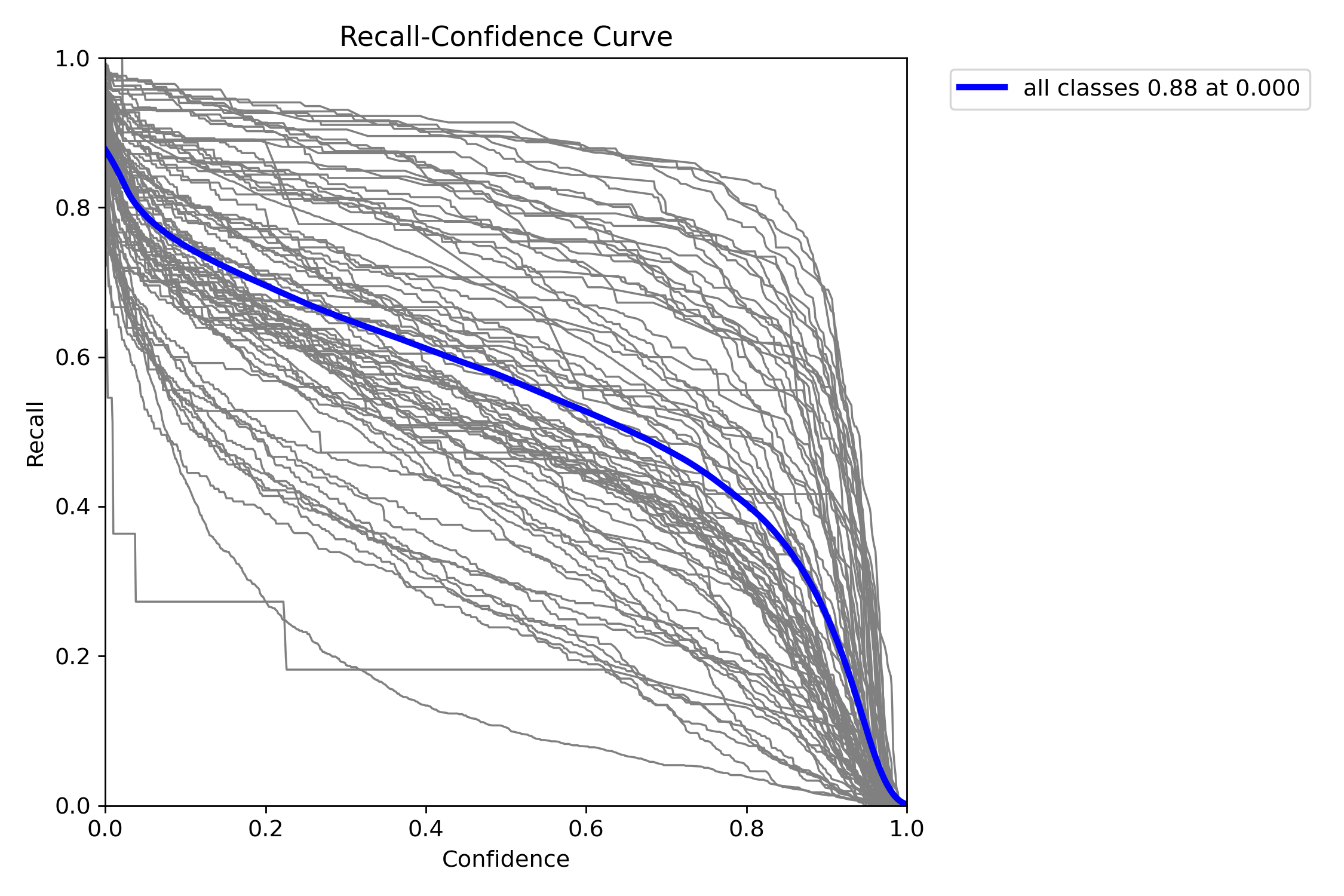

대체로 낮은 거 같다. 최적의 confidence threshold를 찾으려는 시도를 안해보고 처음에 세팅해볼만한 값이 0.5일텐데 0.5 로 두면 Recall 이 크게 저하될 수 있음(=미탐률 증가)을 아래 그래프(상: F1-Score, 하: Recall)에서 확인할 수 있다.

YOLOv8n

YOLOv8s

YOLOv8m

YOLOv8l

YOLOv8x

'Deep Learning' 카테고리의 다른 글

댓글

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

링크

TAG

- 위상 정렬 알고리즘

- LCA

- ㅂ

- 백준 1766

- PyCharm

- 순열

- Lowest Common Ancestor

- 백준 11437

- cosine

- C++ Deploy

- 자료구조

- 백준

- MOT

- FairMOT

- 인공지능을 위한 선형대수

- 이분탐색

- 단축키

- 가장 긴 증가하는 부분 수열

- 백준 11053

- 문제집

- 조합

- 파이참

- 백트래킹

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

글 보관함