티스토리 뷰

PyTorch Lightning 기반으로 프로젝트를 구현중이다.

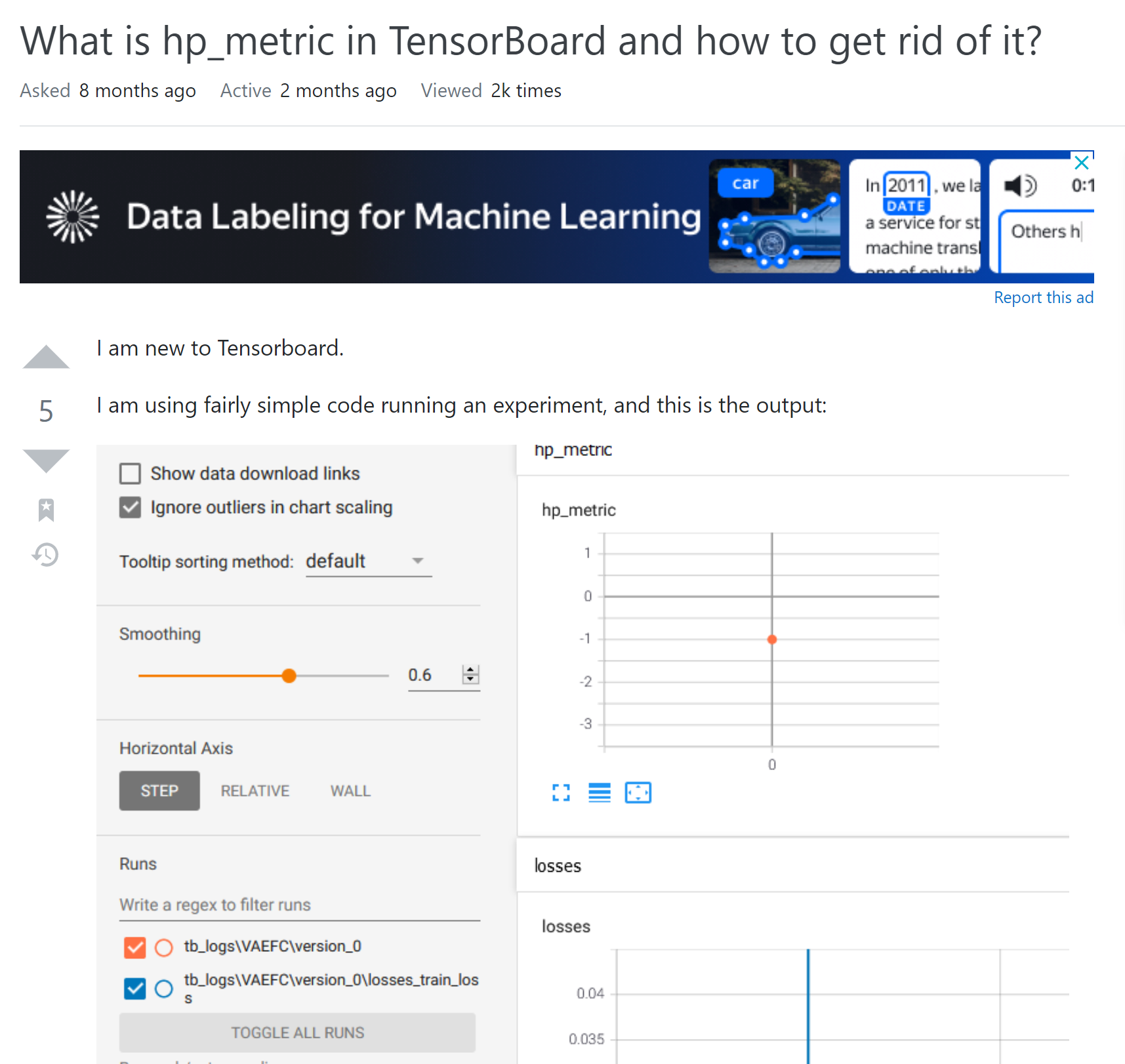

Logger를 TensorBoard로 세팅하고 학습시키니 TensorBoard 파일에 hp metric이란 그래프가 떡하니 출력된다. 관련 글들을 좀 찾다보니 하이퍼 파라미터 서치에 도움을 주기 위한 그래프 같은데 굳이 출력할 필요가 없었다. 불필요한 정보가 출력되고 있으면 괜히 뭔가 마음이 불편하다. 근데 PyTorch Lightning이 캡슐화가 너무 잘 돼있다보니 어딜 건드려야 이 그래프를 지울 수 있는지 모르겠다... 구글링을 해보니 이미 나와 같은 생각을 하신 분이 계셨다.

해결법은 간단했다.

TensorBoardLogger 클래스의 객체를 생성할때 함수인자 default_parameter 를 False로 세팅해주면 된다.

logger = TensorBoardLogger(...,

default_hp_metric=False)

trainer = pl.Trainer(...,

logger=logger)

What is hp_metric in TensorBoard and how to get rid of it?

I am new to Tensorboard. I am using fairly simple code running an experiment, and this is the output: I don't remember asking for a hp_metric graph, yet here it is. What is it and how do I get rid...

stackoverflow.com

'Deep Learning > PyTorch' 카테고리의 다른 글

| [PyTorch] Batchnorm Implementation (0) | 2022.03.21 |

|---|---|

| [PyTorch] BN Layer Freeze (0) | 2022.03.19 |

| [PyTorch Lightning] 관련 링크 모음 (0) | 2021.08.31 |

| YOLOv4, Scaled YOLOv4 를 구현함에 있어 유의할 점 (4) | 2021.08.10 |

| [ONNX, PyTorch, TensorRT] GatherElements 지원 이슈 (0) | 2021.06.30 |

댓글

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

링크

TAG

- 문제집

- 백준 1766

- cosine

- 가장 긴 증가하는 부분 수열

- MOT

- ㅂ

- C++ Deploy

- FairMOT

- Lowest Common Ancestor

- 백준

- 자료구조

- PyCharm

- 백준 11437

- 조합

- 파이참

- 위상 정렬 알고리즘

- 단축키

- 이분탐색

- 순열

- 백트래킹

- 인공지능을 위한 선형대수

- LCA

- 백준 11053

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

글 보관함